A Febrero del 2025

Curador: Oscar Acosta con uso de ChatGPT4

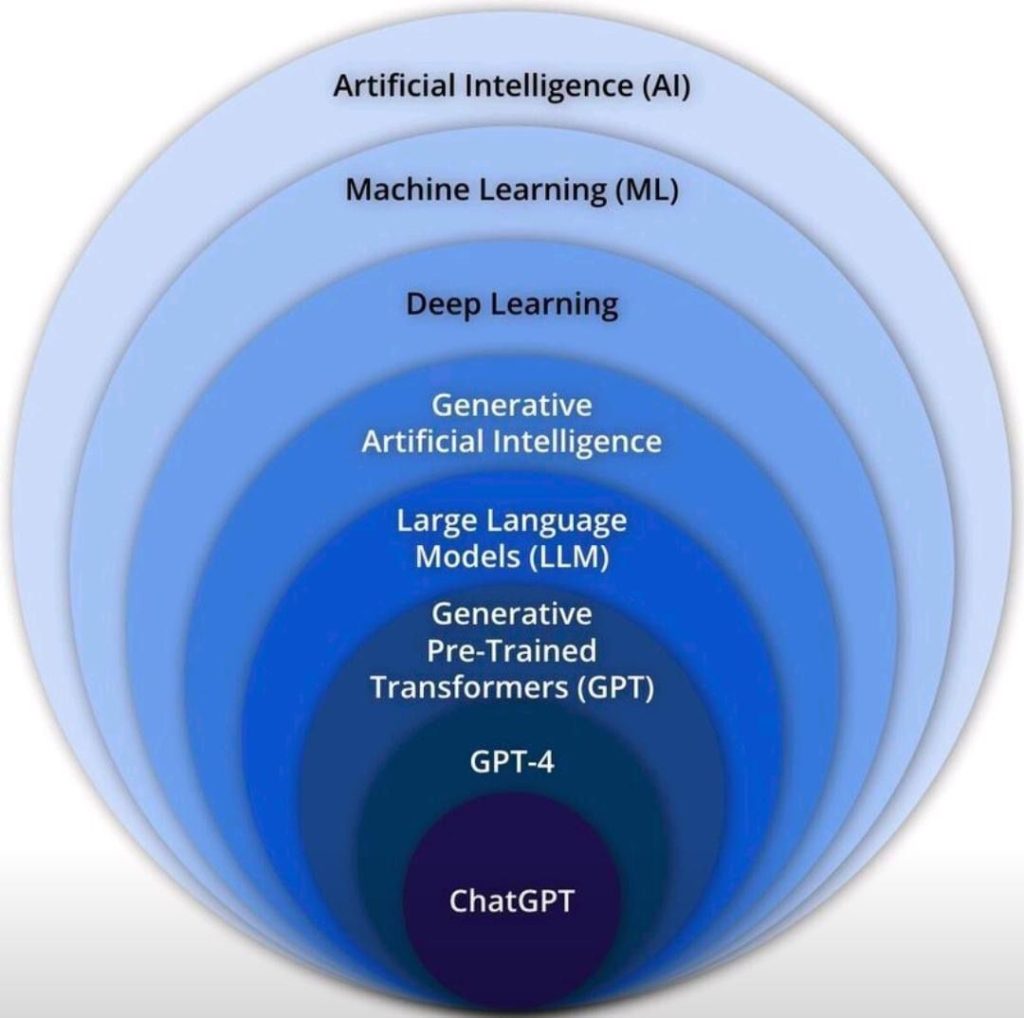

1. Introducción a la Inteligencia Artificial (IA). La inteligencia artificial (IA) se ha convertido en una de las áreas más revolucionarias y de rápido desarrollo en la tecnología y la ciencia. Desde su conceptualización en la década de 1950, la IA ha evolucionado significativamente. Originalmente, la IA se centraba en replicar las capacidades cognitivas humanas. Hoy en día, se define como la capacidad de una máquina para imitar la inteligencia humana. Esto incluye habilidades como el aprendizaje, la resolución de problemas, el reconocimiento de patrones, la comprensión del lenguaje natural y la percepción visual.

La IA no es sólo ChatGPT, la inteligencia artificial se ha integrado en numerosos aspectos de la vida cotidiana y ha transformado industrias enteras desde hace muchos años. Desde bots en videojuegos de 007, cámaras de seguridad, asistentes personales como Alexa hasta sistemas avanzados en medicina, finanzas y manufactura, la IA es el tsunami que se acerca rápidamente y que cambiará el mundo como lo conocemos en menos tiempo de lo que puedas imaginar. Este rápido desarrollo se debe en gran parte a los avances exponenciales en el poder de cómputo, la disponibilidad de grandes conjuntos de datos (big data) y las mejoras en algoritmos de aprendizaje automático de los últimos años.

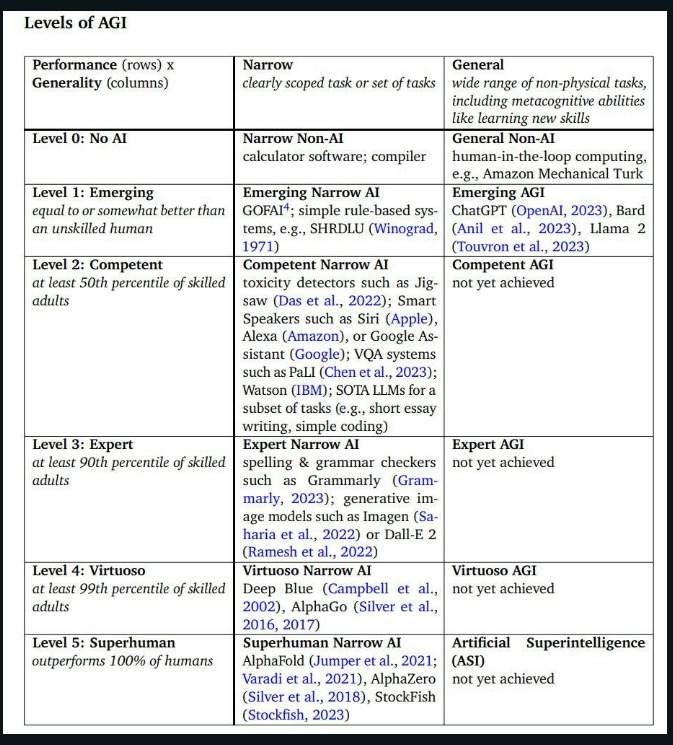

2. Tipos de IA. La inteligencia artificial se puede clasificar en tres categorías principales según su nivel de capacidad y complejidad:

- Inteligencia Artificial Estrecha (IA Débil): Este es el tipo de IA más comúnmente implementado hoy en día. Se centra en realizar tareas específicas de manera autónoma, pero dentro de un rango limitado. Por ejemplo, los sistemas de recomendación de productos en sitios web de comercio electrónico o los asistentes virtuales como Siri de Apple. Estos sistemas no poseen conciencia o inteligencia general; simplemente procesan datos e información dentro de un marco predefinido.

- Inteligencia Artificial General (AGI o IA Fuerte): Esta forma de IA aún está en desarrollo y representa la capacidad de un sistema para entender, aprender y aplicar su inteligencia a cualquier problema, de manera similar a como lo haría un ser humano. Una IA general sería capaz de realizar cualquier tarea intelectual que un humano puede hacer. Esta categoría de IA plantea cuestiones tanto técnicas como éticas, ya que se acerca a la replicación de la conciencia humana.

- Superinteligencia Artificial (Supera al 100% de los humanos): Es un concepto teórico que se refiere a una forma de inteligencia artificial que no solo imita o replica las capacidades humanas, sino que las supera significativamente. La superinteligencia implica una máquina que podría superar a los humanos en prácticamente todas las actividades, incluyendo la creatividad, la toma de decisiones y el razonamiento. La idea de superinteligencia plantea interrogantes profundos sobre el futuro de la humanidad y la ética de crear máquinas que puedan superar nuestras capacidades.

3. Aprendizaje Automático (Machine Learning) El Aprendizaje Automático (ML) es una rama fundamental de la IA que permite a las máquinas aprender de los datos y mejorar su rendimiento en tareas específicas. En lugar de ser programadas con reglas específicas, estas máquinas aprenden patrones y toman decisiones basadas en datos. Hay tres tipos principales de aprendizaje automático:

- Aprendizaje Supervisado: Implica entrenar modelos en un conjunto de datos etiquetado. Aquí, el sistema aprende a partir de ejemplos que ya tienen respuestas conocidas. Por ejemplo, en la detección de spam en correos electrónicos, el sistema se entrena con correos ya marcados como ‘spam’ o ‘no spam’.

- Aprendizaje No Supervisado: En este caso, los modelos se entrenan con datos no etiquetados. El sistema trata de identificar patrones y estructuras por sí mismo. Un ejemplo común es la segmentación de clientes en marketing, donde se agrupan clientes con características similares sin etiquetas previas.

- Aprendizaje por Refuerzo: Aquí, los modelos aprenden a tomar decisiones mediante la prueba y error, recibiendo ‘recompensas’ o ‘penalizaciones’. Este método es ampliamente usado en sistemas que requieren una serie de decisiones, como los autos autónomos o en juegos como el Go o el ajedrez.

4. Aprendizaje Profundo (Deep Learning) una subcategoría del ML, implica redes neuronales con muchas capas (conocidas como redes neuronales profundas). Estas redes son capaces de aprender características de alto nivel a partir de datos, lo que es fundamental para tareas como el reconocimiento de voz, la traducción de idiomas y la visión por computadora.

- Las redes neuronales artificiales están inspiradas en las redes neuronales biológicas del cerebro humano. Consisten en capas de nodos (neuronas), cada una realizando una operación matemática simple. La información se pasa a través de estas capas, permitiendo que la red realice tareas complejas de procesamiento de datos.

- Las redes neuronales profundas son a menudo la arquitectura elegida para entrenar modelos generativos debido a su capacidad para manejar complejidades y patrones sutiles en los datos.

5. La Inteligencia Artificial Generativa se refiere a un subcampo de la IA centrado en crear o generar contenido nuevo y original. Esto puede incluir texto, imágenes, música, voz, y otros tipos de medios. La clave es que la IA no solo está analizando o procesando datos, sino creando algo nuevo basado en lo que ha aprendido.

Estos sistemas utilizan técnicas como redes generativas antagónicas (GANs) y autoencoders variacionales para aprender cómo se compone el contenido en sus datos de entrenamiento y luego generar nuevas creaciones que son similares en estructura o estilo. Por ejemplo, una GAN entrenada en fotografías puede generar nuevas imágenes que parecen realistas pero que no existen en el mundo real.

6. Analogía del entrenamiento de un Modelo de Lenguaje Grande (LLM) Entrenar un modelo de lenguaje avanzado como GPT-3 es un proceso que combina tecnología de punta con una comprensión profunda del lenguaje humano. A diferencia de las simples predicciones de palabras, estos modelos se adentran en el corazón del lenguaje, aprendiendo patrones, contextos, semántica, tono y estilo a gran escala.

Para entender cómo se logra esto, pensemos en los procesadores utilizados en estas tareas. Un CPU, en términos humanos, sería como leer una palabra a la vez. Es eficiente, pero lineal y limitado en velocidad. Por otro lado, un GPU sería como tener varios ojos, cada uno leyendo diferentes líneas de texto simultáneamente, lo que permite un procesamiento más rápido y en paralelo. Sin embargo, es en los TPUs donde realmente se ve la magia. Estos son como tener cientos o miles de ojos, cada uno capaz de comprender una página entera de texto en un vistazo. Los TPUs están diseñados específicamente para el aprendizaje automático, lo que les permite manejar enormes volúmenes de datos y realizar cálculos complejos a una velocidad impresionante (ojos para leer la información, aprender y generar el modelo).

Durante el entrenamiento, un modelo como ChatGPT se expone (como radiografías) a enormes cantidades de texto (libros, artículos, sitios web, etc.). Sin embargo, el modelo no «almacena» todo este texto. Cuando ChatGPT proporciona información específica, como la fecha de fundación de México, lo hace basándose en los patrones, estructuras lingüísticas y relaciones entre palabras y conocimientos aprendidos durante su entrenamiento, y no porque haya «guardado» esta información de manera explícita como lo haría una base de datos.

Lo que el modelo retiene son los parámetros (como los pesos de las conexiones neuronales) que se ajustan durante el entrenamiento. Estos parámetros son mucho menos voluminosos que los datos de entrenamiento originales. Por ejemplo, aunque el modelo se entrene con terabytes de texto, el modelo en sí (sus parámetros) podría ocupar mucho menos espacio, como decenas o cientos de gigabytes.

Los modelos de lenguaje, o LLM, funcionan como “prismas” a través de los cuales nuestras preguntas o textos son reflejados. Al pasar por el procesamiento del modelo, estos prismas tienen la capacidad de transformar nuestras consultas en predicciones o respuestas coherentes y contextuales.

El tamaño de este «prisma digital» es crucial. Se refiere al tamaño o capacidad del modelo, medido en tokens, que determina cuánta información puede procesar y generar el modelo. Un modelo más grande, con más tokens, tiene una capacidad mayor para capturar y reflejar información compleja, ofreciendo respuestas más detalladas y matizadas.

En resumen, el proceso de entrenar un modelo de lenguaje es un equilibrio entre hardware especializado y una comprensión sofisticada del lenguaje. Los TPUs juegan un papel crucial, permitiendo un procesamiento de datos a una escala y velocidad que sería imposible con tecnologías más convencionales. El resultado es un modelo que no solo predice palabras, sino que entiende y genera lenguaje de manera similar a como lo haría un humano.

La cantidad de tokens que un modelo puede manejar simultáneamente está directamente relacionada con el tamaño de su ventana de contexto (memoria de conversación). En esencia, la ventana de contexto de un modelo de lenguaje se define por la cantidad máxima de tokens que el modelo puede procesar en un único turno de entrada. Esta limitación está intrínsecamente vinculada a la arquitectura y capacidad del modelo.

7. Aspectos que afectan la efectividad o capacidad de procesamiento del modelo

- Capacidad de Ventana de Contexto: Determina cuántos tokens (palabras o caracteres) puede considerar el modelo al responder. Por ejemplo, ChatGPT-3.5 tiene una ventana de contexto de alrededor de 2,048 tokens, mientras que GPT-4 puede manejar hasta 4,096 tokens.

- Calidad del Entrenamiento:Incluye la diversidad, cantidad y calidad de los datos utilizados para entrenar el modelo. Por ejemplo, un modelo entrenado con una amplia gama de textos de literatura, artículos científicos y conversaciones cotidianas sería más robusto y menos sesgado.

- Arquitectura del Modelo:

- Transformers en NLP: Modelos como GPT y BERT utilizan la arquitectura «Transformer», eficaz para el procesamiento del lenguaje natural. Esta arquitectura se destaca por su capacidad para manejar secuencias largas de datos y su eficiencia en el aprendizaje de relaciones complejas en el texto.

- Red Neuronal Convolucional (CNN): Especialmente eficaz en el procesamiento de imágenes. Las CNNs son excelentes para reconocer patrones espaciales en datos visuales. Un ejemplo de su aplicación es en Google Photos, donde se utilizan para reconocer y clasificar rostros en imágenes.

- Árboles de Decisión: Utilizados para la toma de decisiones y clasificación. A través de un enfoque de tipo ‘si-entonces’, estos algoritmos dividen los datos en conjuntos más pequeños y más manejables.

- Máquinas de Vectores de Soporte (SVM): Son modelos de aprendizaje supervisado utilizados para la clasificación y regresión de datos. SVMs son eficientes en espacios de alta dimensión y en casos donde el número de dimensiones es mayor que el número de muestras.

- Entre muchas otras: RNN, Autoencoders, GNN, GAN, etc.

- Referencias Interesantes:

- Calificación en pruebas ELO de diferentes LLM ChatBot Arena

- MMLU benchmark AI Benchmark entre Modelos de AI para Lenguaje

- Ejemplo de Modelos Independientes: Inflection-2: The Next Step Up

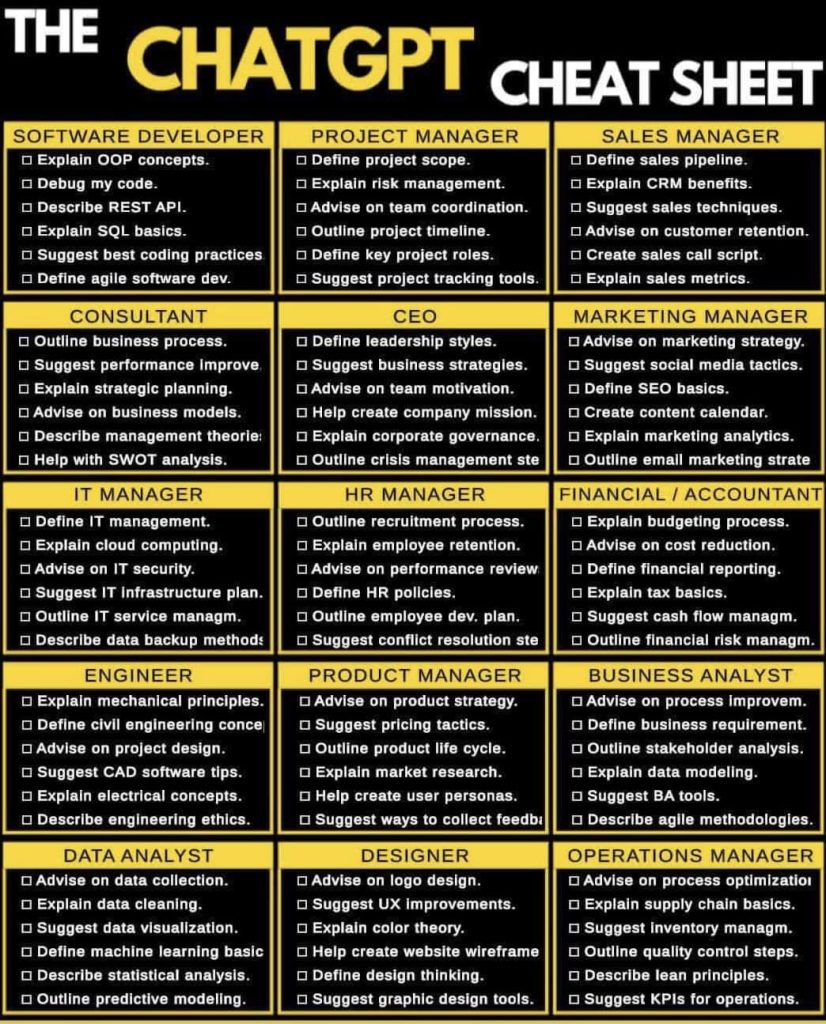

8. Aplicaciones de IA en Negocios La Inteligencia Artificial ha encontrado un terreno fértil en el mundo empresarial, donde sus aplicaciones están transformando diversas industrias y procesos. Algunos ejemplos destacados incluyen:

- Análisis de Datos y Toma de Decisiones: Las empresas utilizan la IA para analizar grandes volúmenes de datos y obtener insights valiosos, lo que ayuda en la toma de decisiones estratégicas. Herramientas de IA pueden identificar patrones y tendencias que no son evidentes para el análisis humano.

- Automatización de Procesos de Negocio (RPA): La IA está permitiendo la automatización de tareas repetitivas y de bajo valor, lo que mejora la eficiencia y reduce los costos. Esto incluye tareas como la entrada de datos, la gestión de inventarios y la contabilidad.

- Atención al Cliente y Chatbots: Los chatbots impulsados por IA están revolucionando la atención al cliente, proporcionando respuestas rápidas y personalizadas a las consultas de los clientes. Estos sistemas pueden aprender de interacciones pasadas para mejorar su eficacia.

- Marketing Personalizado: La IA permite a las empresas crear experiencias de cliente altamente personalizadas, analizando datos de comportamiento para ofrecer recomendaciones y contenido relevante.

- Detección de Fraude y Seguridad Cibernética: La IA juega un papel crucial en la identificación de actividades sospechosas y la prevención de fraudes, especialmente en el sector financiero. Los sistemas de IA pueden detectar patrones anómalos que indican fraude o ataques cibernéticos.

|  |

9. Big Data y Análisis Predictivo Big Data se refiere a conjuntos de datos tan grandes y complejos que las aplicaciones tradicionales de procesamiento de datos no son suficientes para manejarlos. La IA, especialmente el aprendizaje automático y el análisis predictivo, es fundamental para extraer valor de Big Data.

- Extracción de Información Valiosa: La IA puede procesar y analizar grandes cantidades de datos para descubrir información útil, como tendencias de mercado, preferencias de los consumidores y eficiencias operativas.

- Análisis Predictivo: Utilizando algoritmos de aprendizaje automático, las empresas pueden predecir tendencias futuras y comportamientos de los consumidores. Esto es crucial en áreas como la planificación de inventario, la gestión de la cadena de suministro y la previsión de ventas.

- Personalización y Segmentación: Big Data combinado con IA permite a las empresas segmentar a sus clientes de manera más efectiva y personalizar sus estrategias de marketing y ventas para grupos específicos de clientes.

- Mejora de la Toma de Decisiones: El análisis predictivo proporciona a los líderes empresariales información basada en datos para la toma de decisiones estratégicas, reduciendo la incertidumbre y mejorando la precisión de sus previsiones.

10. Riesgos e implicaciones El avance de la inteligencia artificial (IA) trae consigo numerosos beneficios, pero también plantea importantes desafíos y riesgos potenciales. Es crucial abordar estos aspectos para garantizar un desarrollo y uso responsable de la IA.

- Sesgos en los Datos y Decisiones: Los modelos de IA, incluyendo LLM y sistemas de aprendizaje automático, pueden perpetuar o amplificar sesgos presentes en los datos de entrenamiento. Esto puede llevar a decisiones injustas o discriminatorias en áreas como contratación laboral, préstamos bancarios o justicia penal.

- Privacidad y Seguridad de Datos: La recopilación y análisis masivos de datos personales por sistemas de IA plantean preocupaciones significativas de privacidad. Además, la IA puede ser utilizada para crear o difundir información engañosa, como deepfakes.

- Autonomía y Control: La creciente autonomía de los sistemas de IA, especialmente en sectores críticos como transporte (vehículos autónomos) y salud, plantea cuestiones sobre la confiabilidad, seguridad y control humano sobre estas tecnologías.

- Uso Malintencionado: La IA puede ser utilizada para fines nefastos, como la creación de malware avanzado, ataques cibernéticos automatizados, sistemas de vigilancia invasivos e inclusive para crear imágenes falsas íntimas. Si deseas saber como retirar estas imágenes de internet inician movimientos para poder eliminarlas de internet: https://stopncii.org/

- Transparencia y Explicabilidad: Muchos sistemas de IA actúan como «cajas negras», donde las decisiones no son fácilmente explicables. Esto dificulta la comprensión y la confianza en las decisiones tomadas por la IA, especialmente en contextos críticos (Entender cómo desconectar a Terminator).

11. Vocabulario General en IA

- Token: En el procesamiento del lenguaje, un token es la unidad básica de procesamiento, que puede ser una palabra, vector, pixel, un carácter o un subconjunto.

- Prompt: Un prompt es una entrada inicial dada a un modelo de IA para iniciar su proceso de generación o respuesta.

- LLM (large language model) es un tipo de modelo de lenguaje que se destaca por su capacidad para lograr la comprensión y generación de lenguaje de propósito general.

- GPT (Generative Pretrained Transformer): Es un subtipo de modelo de lenguaje basado en la arquitectura de transformadores, conocido por su capacidad para generar texto coherente y relevante.

- Fine Tuning: Proceso de ajuste fino de un modelo de IA pre-entrenado en un conjunto de datos específico para mejorar su rendimiento en tareas concretas. Ejemplo usar tu propia documentación de la empresa para ser utilizada para un ChatBot.

- Assistants: Asistentes virtuales basados en IA, diseñados para ayudar a los usuarios en tareas diarias, utilizando el procesamiento del lenguaje natural.

- API (Interfaz de Programación de Aplicaciones): Un conjunto de reglas y definiciones que permite que diferentes programas de software se comuniquen entre sí.

- Dalle: Una herramienta de IA diseñada para generar imágenes a partir de descripciones textuales.

- Modelo: En IA, un modelo es una representación matemática de lo que ha aprendido un sistema de aprendizaje automático a partir de los datos de entrenamiento.

- Tensores: Son estructuras de datos multidimensionales, generalmente utilizadas en el aprendizaje automático para almacenar y procesar grandes conjuntos de datos, como imágenes y señales de audio.

- Transformadores: Son un tipo de arquitectura de red neuronal que ha revolucionado el procesamiento del lenguaje natural (NLP). Permiten a las máquinas entender y generar lenguaje con un nivel de complejidad y sutileza que antes no era posible.

- CPU (Unidad Central de Procesamiento): Es el cerebro del ordenador, capaz de realizar una amplia gama de tareas generales. Es versátil pero no especializado en tareas de IA.

- GPU (Unidad de Procesamiento Gráfico): Originalmente diseñadas para gráficos, las GPUs son ideales para la IA debido a su capacidad para realizar cálculos paralelos, procesando grandes bloques de datos simultáneamente.

- TPU (Unidad de Procesamiento Tensorial): Desarrolladas específicamente para tareas de aprendizaje automático, las TPUs están optimizadas para operaciones de alto rendimiento en redes neuronales, ofreciendo un procesamiento más rápido y eficiente para la IA.

- Life (Vida): Proceso que puede mantener su complejidad y replicarse.

- Life 1.0 (Vida 1.0): Vida que evoluciona su hardware y software en la etapa biológica.

- Life 2.0 (Vida 2.0): Vida que evoluciona su hardware pero diseña gran parte de su software en la etapa cultural.

- Life 3.0 (Vida 3.0): Vida que diseña tanto su hardware como su software en la etapa tecnológica.

- Inteligencia: Capacidad para alcanzar objetivos complejos.

- Artificial Intelligence (AI) / Inteligencia Artificial (IA): Inteligencia no biológica.

- Narrow Intelligence (Inteligencia Estrecha): Capacidad para alcanzar un conjunto limitado de objetivos, como jugar ajedrez o conducir un automóvil.

- General Intelligence (Inteligencia General): Capacidad para alcanzar prácticamente cualquier objetivo, incluyendo el aprendizaje.

- Universal Intelligence (Inteligencia Universal): Capacidad para adquirir inteligencia general cuando se tiene acceso a datos y recursos.

- Artificial General Intelligence (AGI) / Inteligencia Artificial General: Capacidad para realizar cualquier tarea cognitiva al menos tan bien como los humanos.

- Human-level AI (IA de Nivel Humano): Inteligencia Artificial General (AGI).

- Strong AI (IA Fuerte): Inteligencia Artificial General (AGI).

- Superintelligence (Superinteligencia): Inteligencia general muy superior al nivel humano.

- Civilization (Civilización): Grupo interactivo de formas de vida inteligentes.

- Conciencia: Experiencia subjetiva.

- Qualia: Instancias individuales de experiencia subjetiva.

- Ética: Principios que rigen cómo debemos comportarnos.

- Teleología: Explicación de las cosas en términos de sus objetivos o propósitos en lugar de sus causas.

- Goal-oriented behavior (Comportamiento Orientado a Objetivos): Comportamiento que se explica más fácilmente por su efecto que por su causa.

- Having a goal (Tener un Objetivo): Exhibir un comportamiento orientado a objetivos.

- Having purpose (Tener un Propósito): Servir los objetivos propios o los de otra entidad.

- Friendly AI (IA Amigable): Superinteligencia cuyos objetivos y propósitos están alineados con los nuestros.

- Cyborg (Ciborg): Híbrido entre humano y máquina.

- Alucinación: respuestas o resultados falsos, ilógicos o engañosos generados por modelos de inteligencia artificial, que pueden parecer verosímiles pero no se basan en la realidad. Ejemplo, cuando le preguntas el cumpleaños de una persona que no existe.

- Intelligence Explosion (Explosión de Inteligencia): Auto-mejora recursiva que conduce rápidamente a la superinteligencia.

- Singularity en AI (Singularidad de la IA): Fenómeno en el que una explosión de inteligencia da lugar a una inteligencia artificial con capacidades impredecibles.

- Universo: La región del espacio desde la cual la luz ha tenido tiempo de alcanzarnos durante los 13.8 mil millones de años desde nuestro Big Bang.

- MCP (Protocolo de Contexto del Modelo): Estándar de código abierto que permite a los modelos de IA interactuar con herramientas y datos externos.

- Narrow AI (Estrecha): Inteligencia Artificial orientada a objetivos precisos y dirigidos, optimizada para alcanzar una meta específica con eficiencia.

- Endogamia digital: Proceso en el que una IA se entrena usando los resultados o modelos generados por otras IAs, reduciendo diversidad y amplificando sesgos.

- PEM (Bomba de Pulso Electromagnético): Descarga de energía capaz de desactivar temporal o permanentemente los sistemas electrónicos que sustentan una IA.

- Ventana de Contexto: Espacio de memoria activa de una IA que determina cuánta información puede procesar simultáneamente.

- Artefacto (en contexto Web para IA): Objeto digital generado o manipulado por una IA, como texto, imagen, modelo o código.

- Tkinter (para Python): Biblioteca estándar de Python para construir interfaces gráficas de usuario (GUI).

- Vibe Coding: Estilo de programación intuitivo y expresivo que prioriza el flujo creativo y la resonancia emocional sobre la estructura formal.

- Normalizar datos (en Vibe Coding): Ajustar la información para mantener coherencia y armonía en el flujo creativo o expresivo del código.

- CSV (Comma-Separated Values): Formato de archivo de texto plano que organiza datos en columnas separadas por comas.

- Árbol de decisiones: Modelo lógico que utiliza ramificaciones para representar elecciones y sus posibles resultados.

- RAG: (Retrieval-Augmented Generation) generación aumentada por recuperación es una técnica de IA que mejora los modelos de lenguaje grandes (LLM) al conectarlos a bases de conocimiento externas para recuperar información relevante antes de generar una respuesta.

12. Ligas interesantes demostrativas:

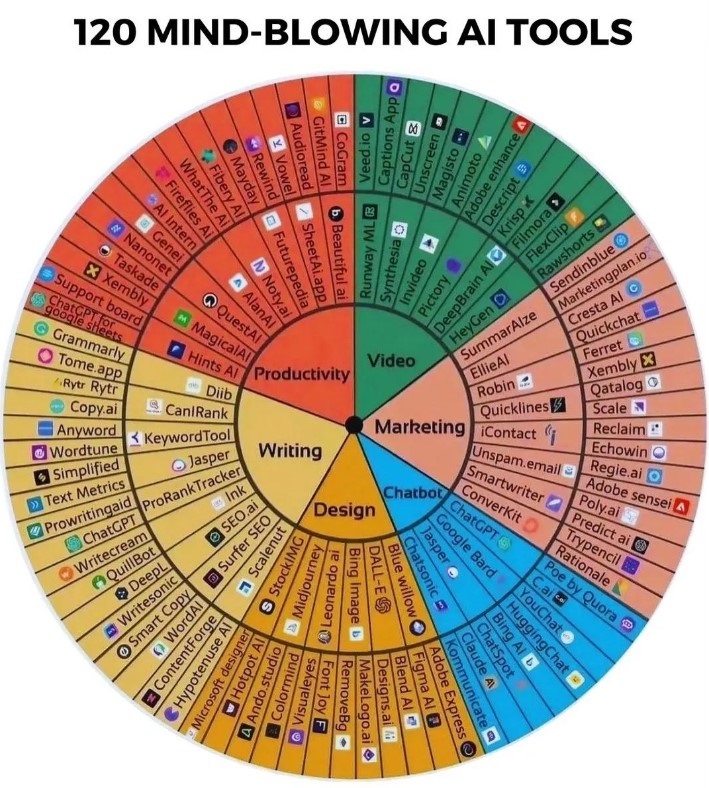

13. Plataformas más utilizadas de Inteligencia Artificial:

https://chatgpt.com :: LLM General, recomendando para uso personal, vida diaria y usos generales de la IA como un poco de Video, Imágenes pero sobre todo conversación.

https://www.vidu.com/es/create = Creación de Video

https://firebase.studio = Creación de Software en la nube asistido con IA

https://gamma.app = Creación de Presentaciones

https://claude.ai/new = Programación avanzada con una vista profesional, artículos académicos e investigación

https://gemini.google.com/app = Ideal para IA empresarial, con muchas aplicaciones como video, imágenes pero sobre todo procesamiento de documentos o temas empresariales

https://firefly.adobe.com = Generación de Imágenes

https://www.chatpdf.com/es = Subir PDFs y buscar información (ChatGPT, Gemini y otros también lo hacen)

https://aistudio.google.com/prompts/new_chat = Herramienta de Google para probar varios nuevos modulos de IA

https://elevenlabs.io/app/speech-synthesis/text-to-speech = Generación de Voz natural y Audio (Ruido para Cine) con IA

https://app.runwayml.com/video-tools = Generación de Video

https://www.midjourney.com/home = Generación de Imágenes creativas o artísticas

https://www.perplexity.ai = LLM No tan conocido, pero bueno para academia, investigación y es económico

https://suno.com/home = Generación de Música

https://notebooklm.google.com = Cargar archivos, documentos o artículos para generar podcast, infogramas, mapas mentales, preguntas, estudiar, etc.

https://www.heygen.com/agent = Generación de Videos con un Avatar de información

https://venice.ai/es = IA sin restricciones, puedes pedir instrucciones de cómo hacer una bomba!

https://www.polybuzz.ai/ = Generación de Imágenes con varias IAs, con costo

https://platform.openai.com/agent-builder = Generación de Agentes con IA de Open Ai

https://sora.chatgpt.com/explore = Generación de Video Profesional de Open AI

https://higgsfield.ai = Conjunto de herramientas de IA experimentales y muy unicas!

Deja una respuesta